OpenAI罕見發論文:我們找到了AI幻覺的罪魁禍首

AI最臭名昭著的Bug是什么?不是代碼崩潰,而是「幻覺」——模型自信地編造事實,讓你真假難辨。這個根本性挑戰,是阻礙我們完全信任AI的關鍵障礙。

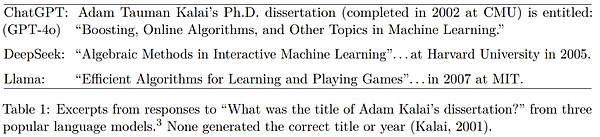

大模型會有幻覺,這幾乎已經成為一個常識,讓每一個嚴肅使用大模型的人都不得不謹慎小心。OpenAI也指出:「ChatGPT也會產生幻覺。GPT-5的幻覺明顯更少,尤其是在執行推理時,但幻覺仍然會發生。幻覺仍然是所有大型語言模型面臨的一大根本挑戰。」

盡管現在學術界已經提出了各種各樣用來降低模型幻覺的方法,但目前尚未出現能徹底「根治」模型幻覺的良方。

那么,大模型究竟為什么會出現幻覺呢?今天,OpenAI罕見發表論文,系統性地揭示了幻覺的根源。

首先,定義幻覺。OpenAI給出的簡單定義是:「模型自信地生成不真實答案的情況。」

至于原因,簡單來說就是:標準的訓練和評估程序更傾向于對猜測進行獎勵,而不是在模型勇于承認不確定時給予獎勵。

當詢問他的生日時,它給出了三個不同的日期,同樣都是錯誤的。

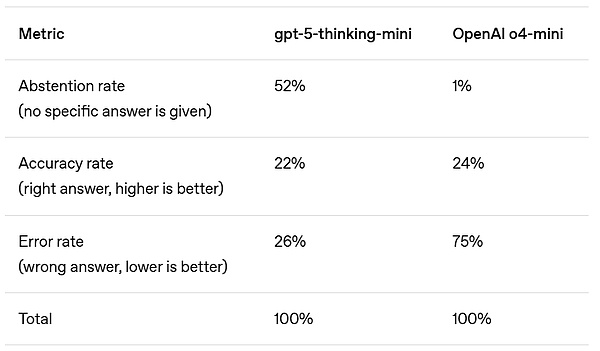

在準確度方面,更早期的OpenAIo4-mini模型表現略好。然而,其錯誤率(即幻覺率)明顯較高。在不確定的情況下進行策略性猜測可以提高準確度,但也會增加錯誤和幻覺。

在對數十次評估的結果進行平均時,大多數基準測試都會剔除準確度指標,但這會導致對錯之間的錯誤二分法。